去年,高通推出了Cloud AI 100,凭借其强劲的性能和高能效赋能云边缘计算、自动驾驶汽车和5G基础设施等领域的人工智能。近日,公司宣布目前该平台正在面向全球部分客户出货,采用Cloud AI 100的商用设备计划于2021年上半年面市。这里有一个问题:为什么以低功耗手机芯片和知识产权(IP)著称的高通公司决定进入成熟竞争者众多的数据中心市场?

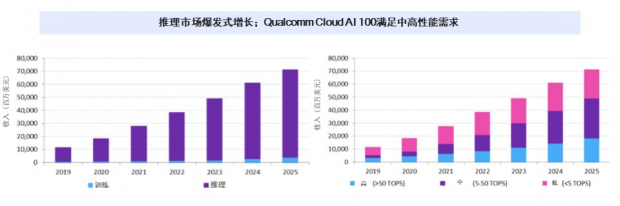

一直以来,高通密切关注数据中心解决方案,其产品具有广受好评的能效和性能表现,这让公司十分适合向数据中心产品市场扩展。此外,高通的5G调制解调器和骁龙移动平台能够帮助公司构建完整的解决方案,避免与仅有AI SoC的小公司进行正面价格战。据估计,2025年AI推理处理可服务市场规模可能超过700亿美元,其中大约500亿美元处于Cloud AI 100的目标市场空间内。

图1:高通Cloud AI 100满足中高性能细分市场的需求

高通发布了什么?

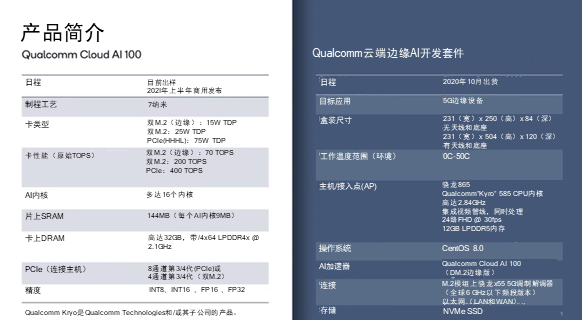

高通还分享了有关Cloud AI 100芯片的技术细节和部分规格参数。高通计划提供一系列设备,包括仅消耗15 TDP的70 TOPS M.2边缘卡、以25瓦功率运行的200 TOPS M.2卡和仅以75W TDP即可实现400 TOPS的数据中心级PCIe平台,可实现高达8 TOPS/瓦的每瓦特性能。

图2:全新Cloud AI 100和边缘AI开发套件产品简介

高通还展示了全新的5G开发套件,计划下月上市。全新云端边缘AI开发套件完整地配备高通X55 5G调制解调器及射频系统和旗舰级的骁龙865处理器。

竞争格局

英特尔至强处理器主导着AI推理市场,但随着AI模型变得越来越复杂,情况正在发生变化。据行业组织估计,AI模型的规模每3.5个月就会翻1倍。这为英伟达等公司和数十家初创企业创造了机会。高通的Cloud AI 100可以说在该领域具有明显的领先优势,其在Resnet50模型上每秒处理约25,000张图片仅需75瓦。我要指出,Resnet50是很小的基准测试程序,尤其与自然语言处理模型(比如谷歌BERT)相比更是如此。但是,在相同基准测试程序中,Cloud AI 100 M2的每瓦特性能大约是前“推理峰值之王”英特尔Goya的四倍,这令人印象深刻。

图3:高通提供的ResNet-50基准测试结果分析

更大更复杂的模型需要更多内存,Cloud AI 100的144MB片上SRAM能够与PCIe卡上高达32 GB的LPDDR4相互结合。此外,该芯片支持一系列数值精度,包括8和16位整数以及16位和32位浮点运算。

另外,Cloud AI 100充分利用高通丰富的移动推理生态系统,并且已提供全套框架和优化工具。

图4:全新AI芯片配备全套软件栈,高通骁龙平台的成功为Cloud AI 100奠定基础

除规格之外,我认为许多客户会选择与知名半导体公司而非初创公司做生意——除非初创公司能够提供显著提升的性能和效率。凭借在骁龙平台上多年的成功经验,高通为AI推理处理提供稳定可靠的质量、性能、效率、软件支持和完整系统生态系统。

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号